19:44 Что умеет Netpeak Spider 3.0: мощный инструмент SEO-анализа сайта | |

Netpeak Spider — инструмент комплексного SEO-анализа сайта. Это десктопное приложение, с помощью которого можно оценить внутреннюю техническую оптимизацию ресурса. Подробнее об использовании Netpeak Spider читайте в обзоре. Что такое Netpeak Spider и зачем его использоватьNetpeak Spider — программа для ПК, с помощью которой можно просканировать любой сайт с открытым доступом. Также инструмент сканирует закрытые сайты. Для этого нужен доступ к ресурсу с правами администратора. То есть Netpeak Spider можно использовать для проверки ресурсов на стадии разработки. Программа собирает с сайта данные о технической оптимизации к требованиям поисковых систем. Netpeak Spider быстро добывает практически всю информацию, которая нужна для оценки SEO ресурса. Например, инструмент собирает данные о битых ссылках, некорректно заполненных метатегах, времени загрузки страниц и так далее. Информацию о внутренней оптимизации сайта можно получить и без Netpeak Spider. Часть данных можно найти в Search Console и «Яндекс.Вебмастер». Часть можно собрать вручную, анализируя сайт через админку или даже без доступа к административной консоли. Но Netpeak Spider экономит время и обеспечивает доступ к комплексной информации в одном интерфейсе. Перед обзором возможностей Netpeak Spider нужно подчеркнуть важный момент. Это инструмент для квалифицированных пользователей. Полученные данные нужно уметь интерпретировать и использовать. Некоторые функции Netpeak Spider однозначно полезные. Но есть здесь и олдскульно-сеошные инструменты, которыми нужно уметь правильно пользоваться. То есть результат использования Netpeak Spider практически полностью зависит от того, в чьих руках этот инструмент.  Как работать с Netpeak Spider

Как работать с Netpeak Spider

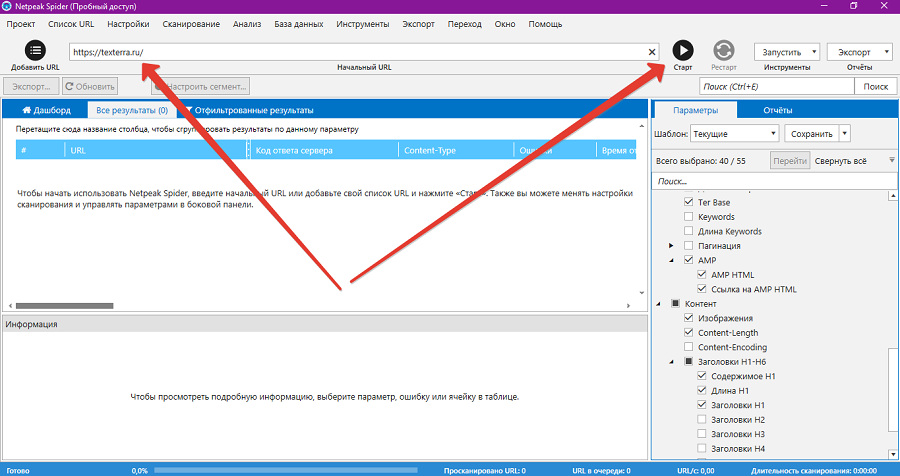

Зарегистрируйтесь на сайте проекта и установите Netpeak Launcher. Это программа, которая загрузит и установит на ваш ПК Netpeak Spider. Активируйте тестовый период и пользуйтесь всеми возможностями программы в течение 14 дней. Чтобы просканировать сайт, запустите программу. Укажите URL и нажмите кнопку «Старт». Для первого сканирования подойдут дефолтные настройки.

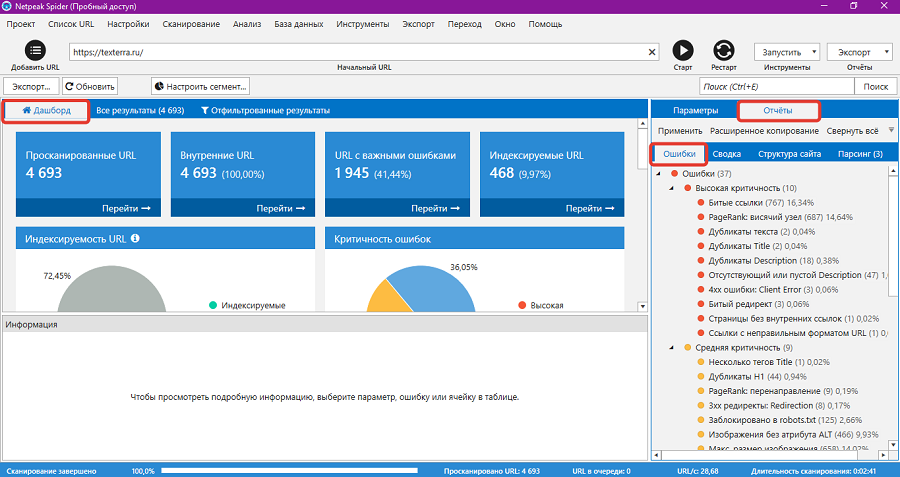

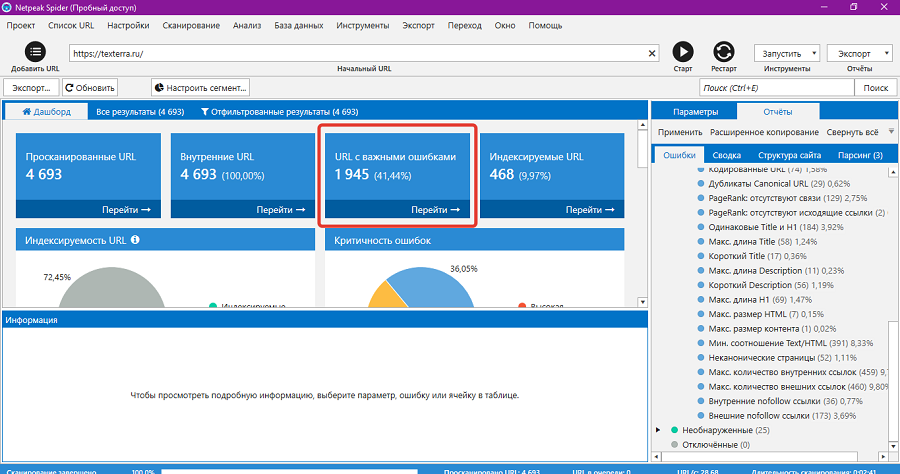

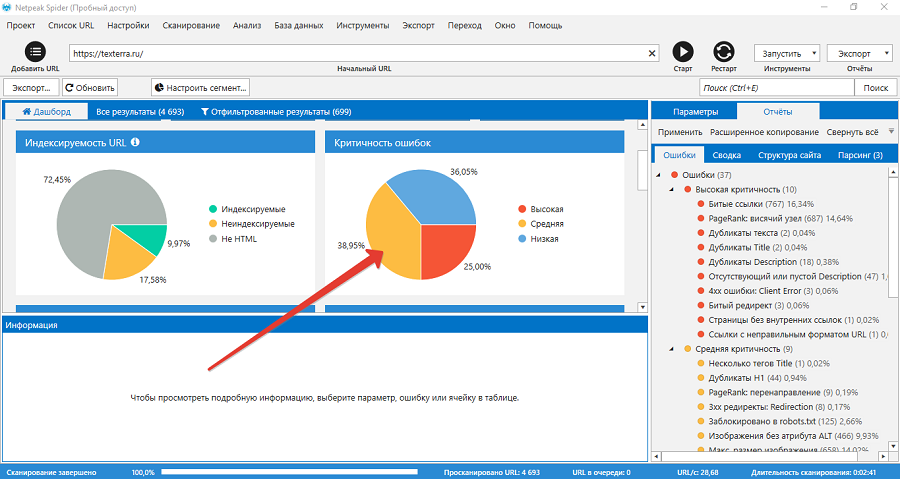

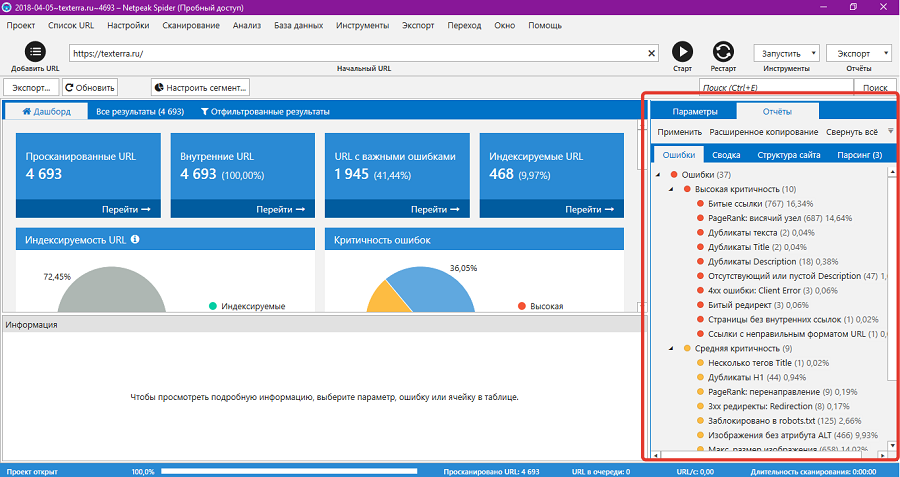

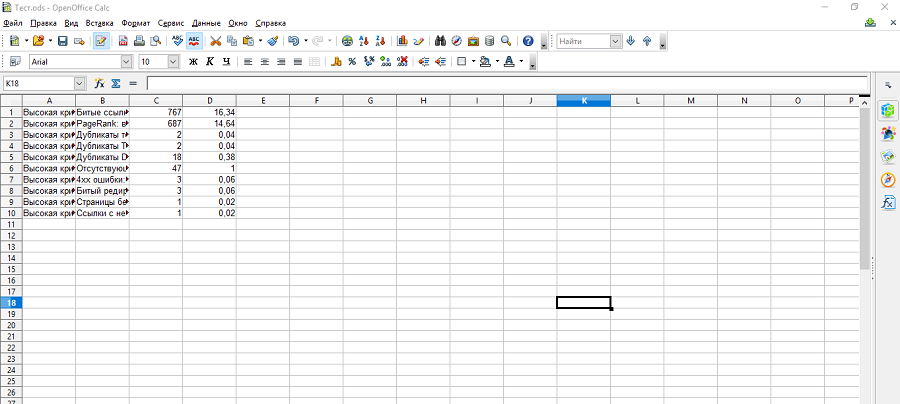

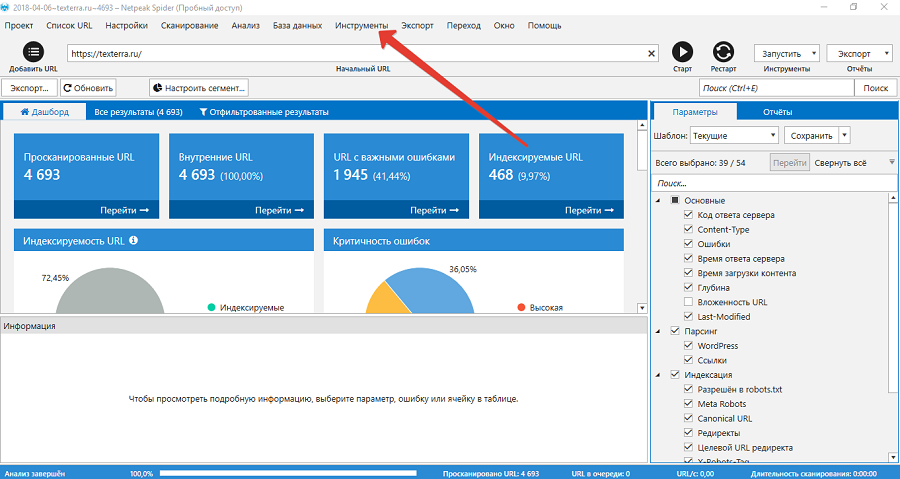

Netpeak Spider одинаково быстро сканирует сайты разных размеров. На обработку сайта «Текстерры» ушло 3 минуты. После завершения сканирования в левой части окна программы открывается дашборд с результатами, а в правой части — отчет в виде списка ошибок.  Какие данные доступны на дашборде

Какие данные доступны на дашборде

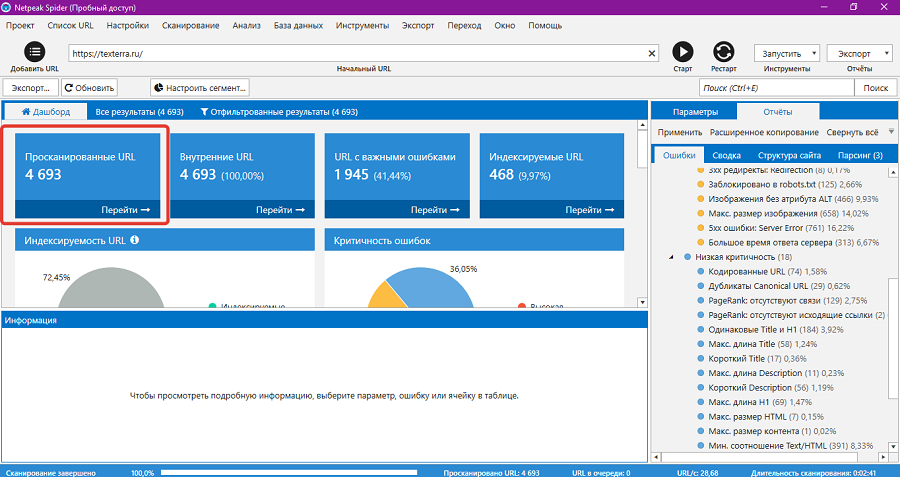

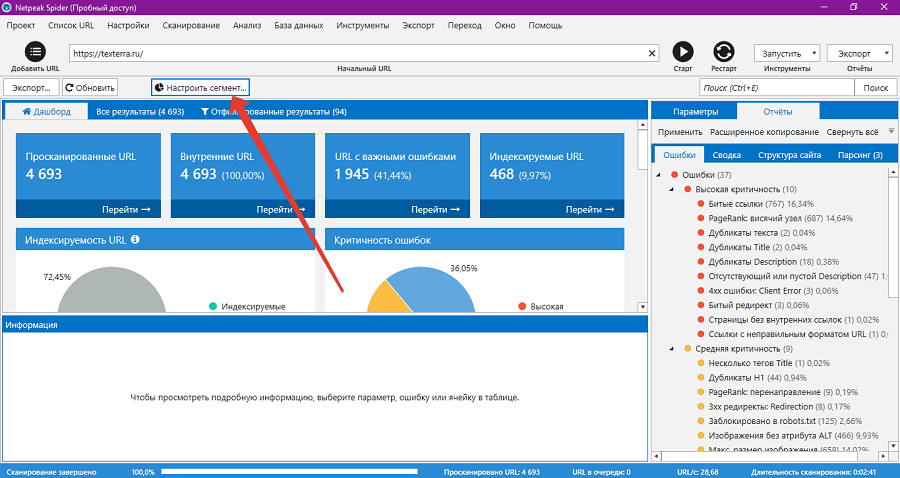

На дашборде отображаются ссылки на отфильтрованные результаты: просканированные URL, внутренние URL, URL с важными ошибками и индексируемые URL. По ссылке «Просканированные URL» доступны все страницы сайта, которые обошел робот Netpeak Spider.

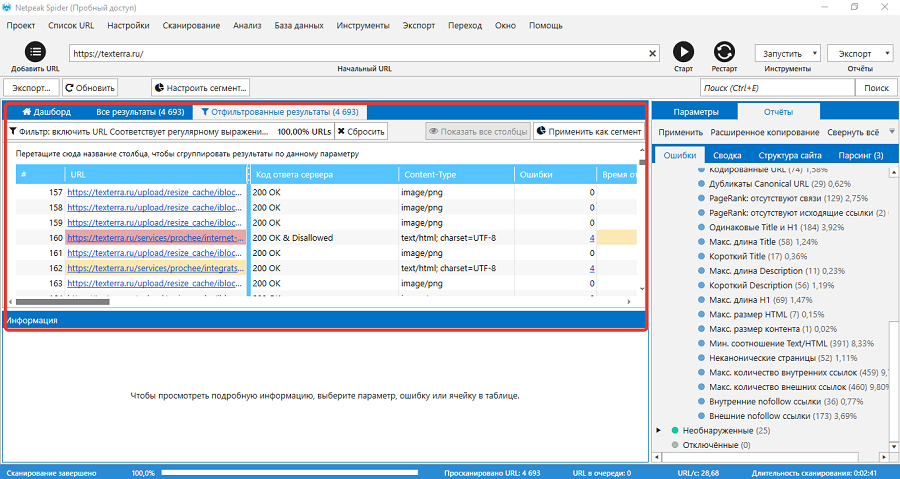

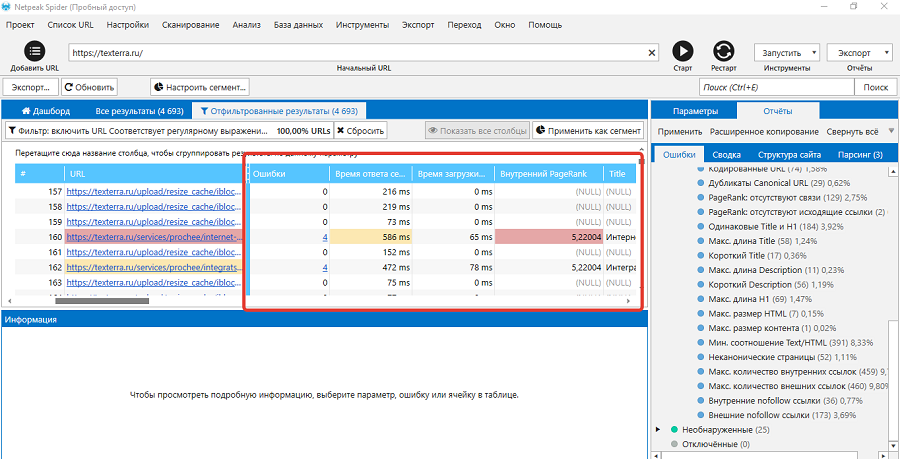

Перейдите по ссылке, чтобы увидеть список просканированных URL. На экране откроется таблица со ссылками и данными по каждой странице. URL с критичными ошибками выделены красным маркером, с ошибками средней и низкой критичности — желтым и синим маркером соответственно. URL без ошибок маркером не выделяются.

В таблице есть данные о каждой странице: код ответа сервера, количество ошибок, время ответа сервера, внутренний PageRank, Title, Description и другая информация.

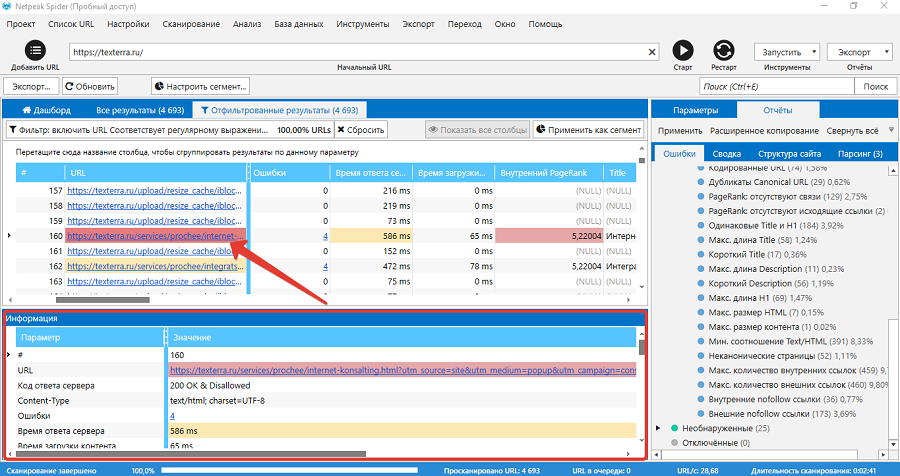

Чтобы просмотреть результаты сканирования конкретного URL, кликните по нему. В окне «Информация» появятся сводные данные.

Ошибки на странице выделены красным, желтым или голубым маркером. На выбранной странице робот нашел четыре ошибки: некорректный URL, некорректную директиву robots.txt, медленный ответ сервера и указание на канонический URL. Ошибки URL и указание на канонический URL по всей видимости связаны с тем, что Netpeak Spider просканировал и включил в отчет URL с UTM-метками. Эта ссылка формируется при переходе на каноническую страницу со всплывающего окна, которое появляется на всех страницах блога «Текстерры». Это объясняет еще одну ошибку, которую видит Netpeak Spider — слишком большой ссылочный вес или PageRank страницы. То есть из четырех найденных ошибок или проблем реального внимания требует только одна: высокое время ответа сервера. Это еще раз подтверждает, что результаты сканирования Netpeak Spider нужно уметь интерпретировать. С помощью ссылок можно быстро перейти к другим отфильтрованным результатам. Например, по ссылке «URL с важными ошибками» откроется список соответствующих страниц.

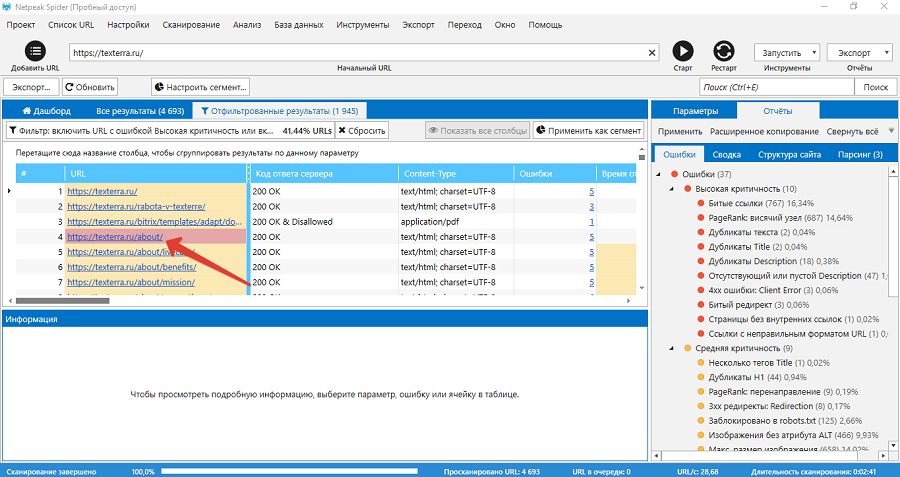

На дашборде открывается список страниц с ошибками с высокой и средней критичностью. Чтобы просмотреть список ошибок на конкретной странице, кликните по ней.

Netpeak Spider нашел на странице несколько ошибок: незаполненный метатег description, большое количество внутренних и внешних ссылок, большое количество изображений, низкое соотношение текста к HTML. Кроме ссылок на отфильтрованные результаты, на дашборде отображаются диаграммы с важными результатами сканирования. Доступны такие данные:

Диаграммы кликабельные. Чтобы просмотреть список страниц с ошибками среднего уровня критичности, нажмите на соответствующий сегмент на диаграмме.

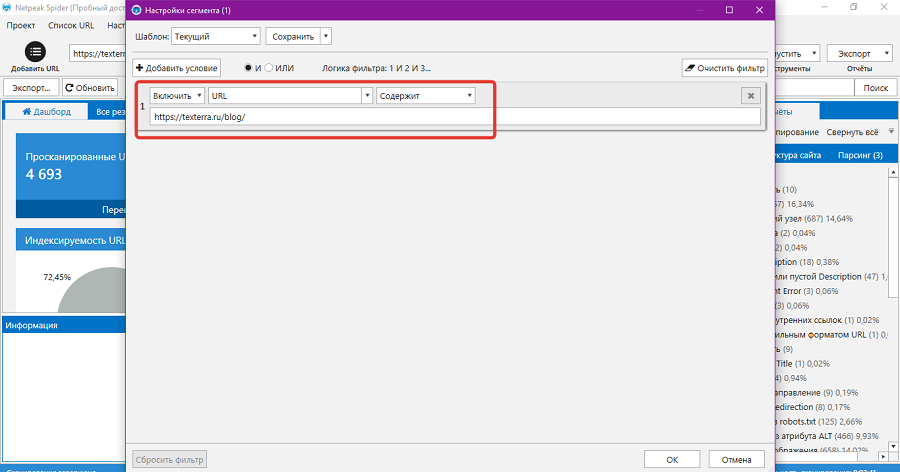

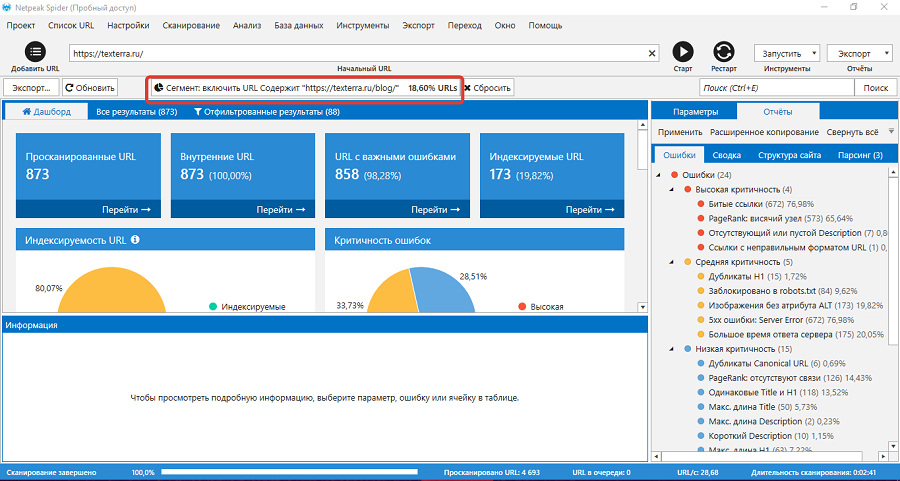

С помощью кнопки «Настроить сегменты» можно получить данные только по определенным URL сайта. Например, можно включить в отчет только публикации в блоге «Текстерры».

Для этого в настройках сегмента создайте фильтр с условием URL содержит. Укажите нужный URL и сохраните фильтр.

После этого на дашборде и в отчетах отобразятся результаты сканирования страниц блога.  Какую информацию найдете в отчетах

Какую информацию найдете в отчетах

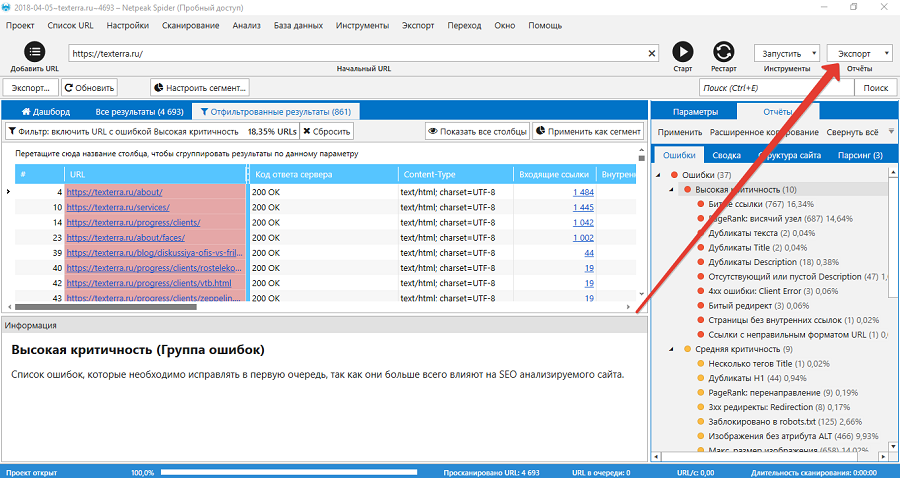

Отчеты доступны в правой части окна программы. Данные сгруппированы на разных вкладках.

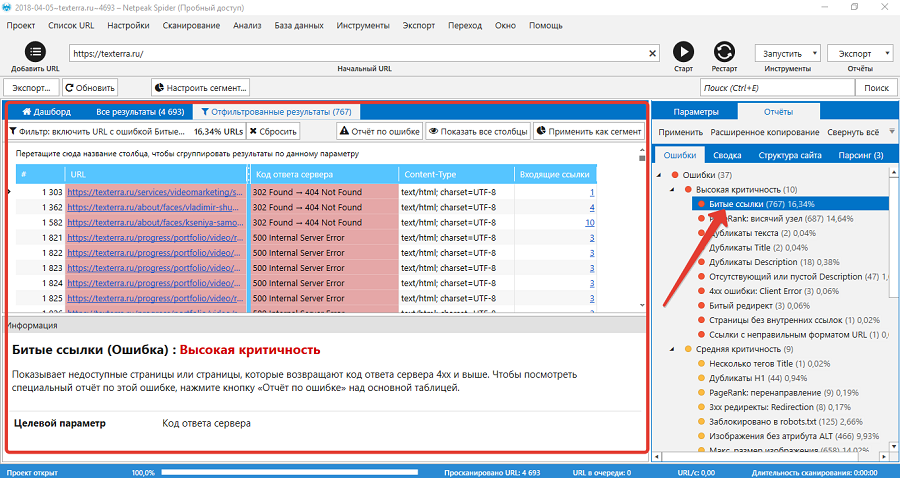

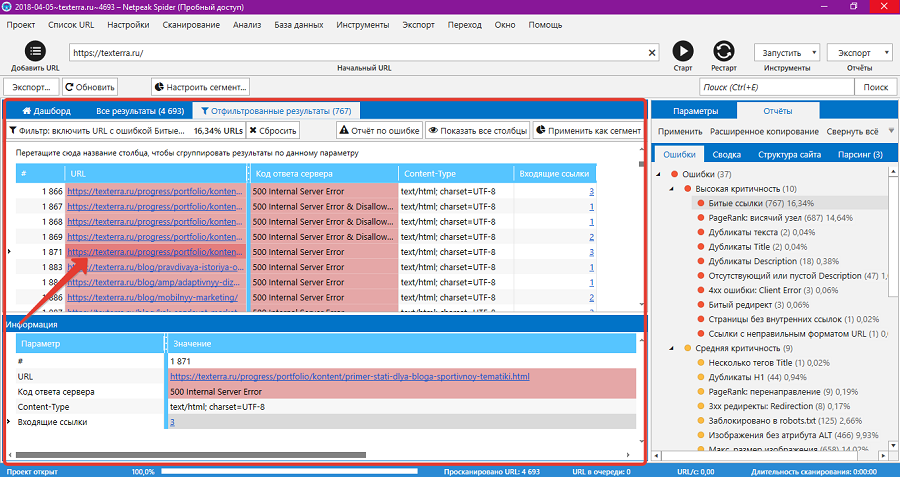

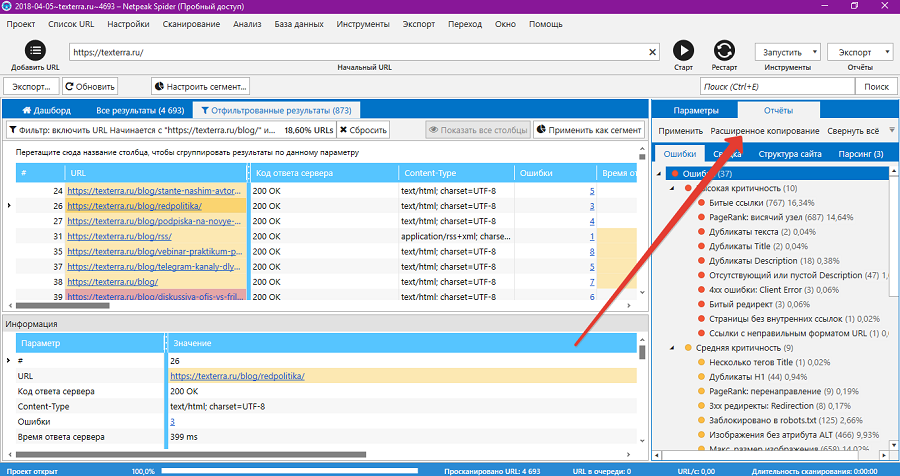

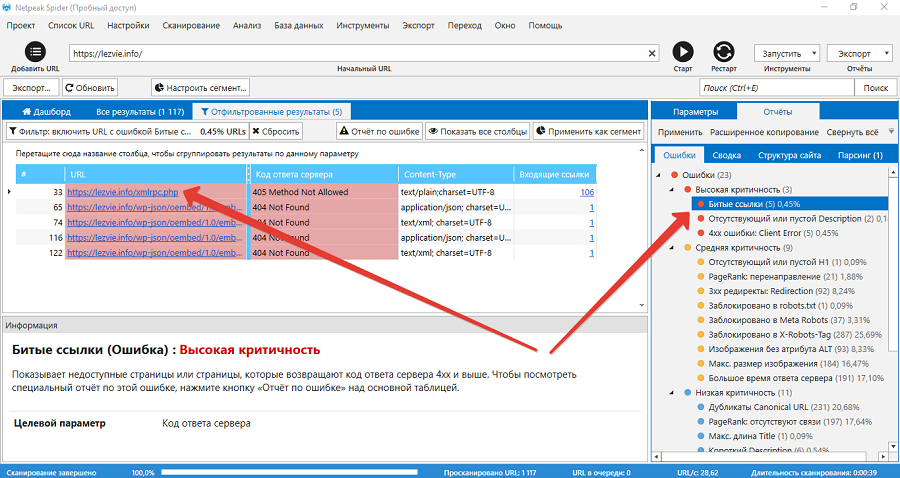

На вкладке «Ошибки» представлены соответствующие сведения. В верхней части списка находятся критичные ошибки, а в нижней некритичные. Пункты в списке ошибок кликабельные. Например, если нажать на ошибку «Битые ссылки», программа выдает список недоступных страниц сайта.

В отфильтрованных результатах можно выбрать конкретный URL и просмотреть данные по нему.

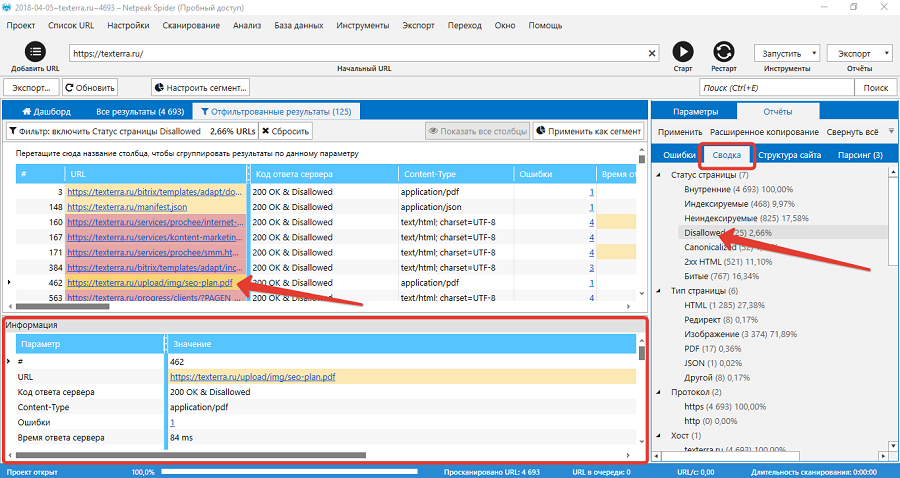

На вкладке «Сводка» сгруппированы данные по статусу и типу страниц, протоколу соединения, хосту, коду ответа сервера и другим параметрам. Например, вы можете выбрать все страницы со статусом Disallowed. В отфильтрованных результатах можно просмотреть данные по конкретной странице, которая закрыта от индексации.

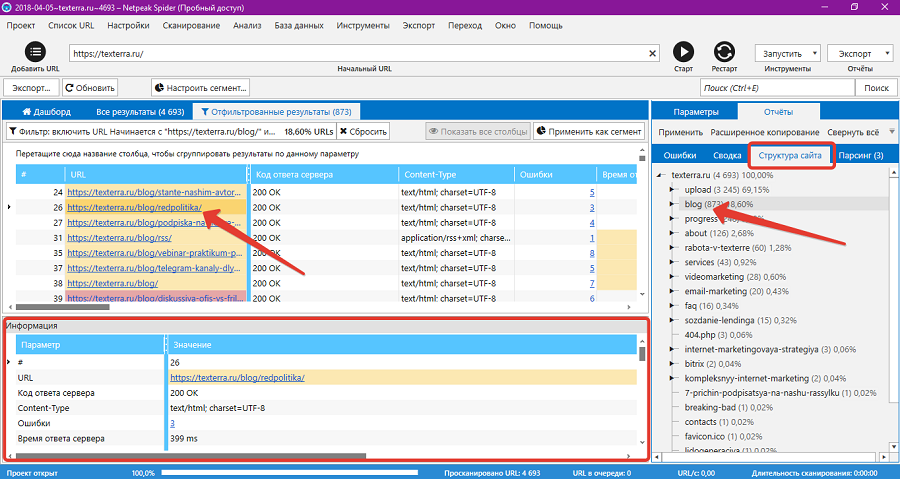

На вкладке «Структура сайта» отображается соответствующая информация. Здесь можно выбрать группу страниц, например, все публикации в блоге. В отфильтрованных результатах доступны данные по отдельным страницам.

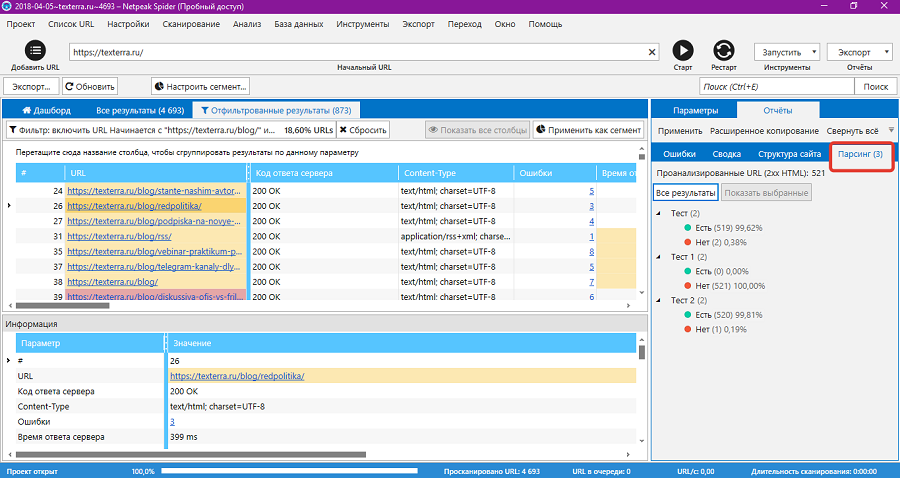

На вкладке «Парсинг» отображаются данные пользовательского парсинга. О настройках этого инструмента пойдет речь ниже.

Данные отчетов можно экспортировать с помощью функции «Расширенное копирование». Для этого выберите отчет и нажмите кнопку «Расширенное копирование».

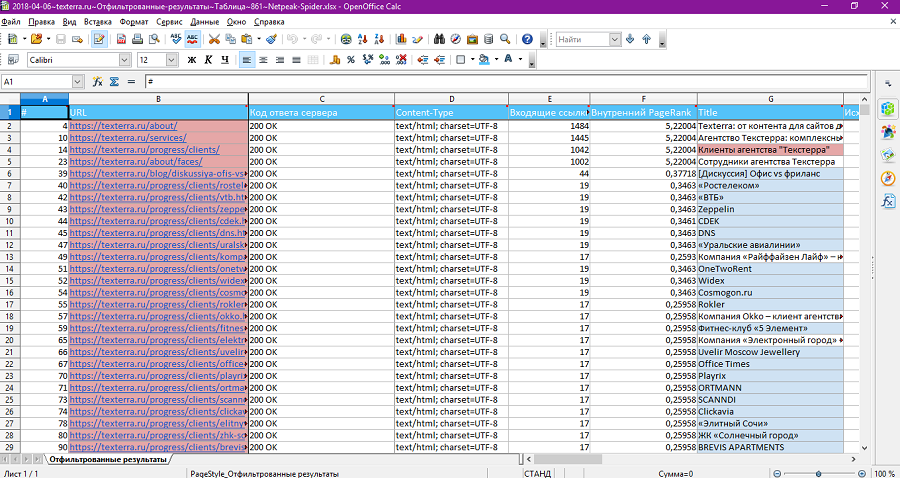

Откройте таблицу и вставьте в нее данные.

Также данные выбранного отчета можно сохранить в таблице с помощью функции «Экспорт – Результаты в текущей таблице».

Программа сохраняет таблицу с отчетом на жестком диске ПК.

Результаты сканирования можно сохранить в программе. Для этого выберите меню «Проект – Сохранить». При следующем запуске программы вы сможете сразу открыть результаты индексирования, а не тратить время на повторное сканирование сайта.  Как настроить сканирование сайта

Как настроить сканирование сайта

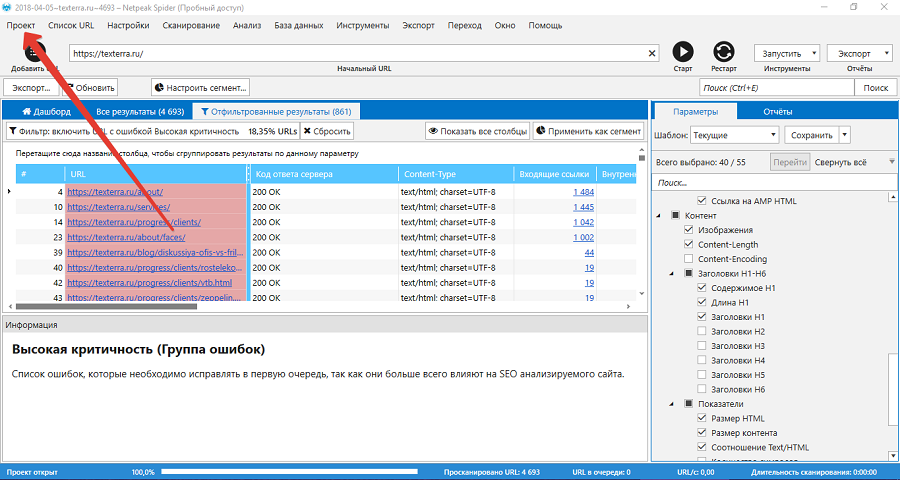

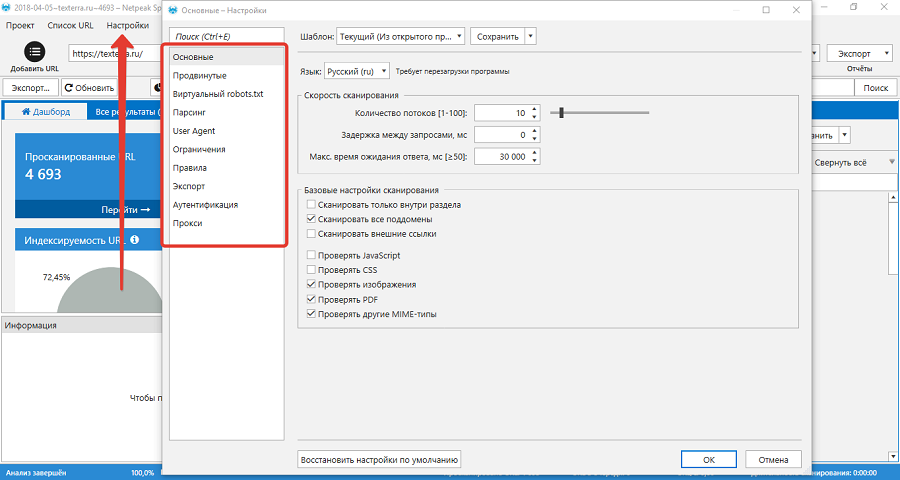

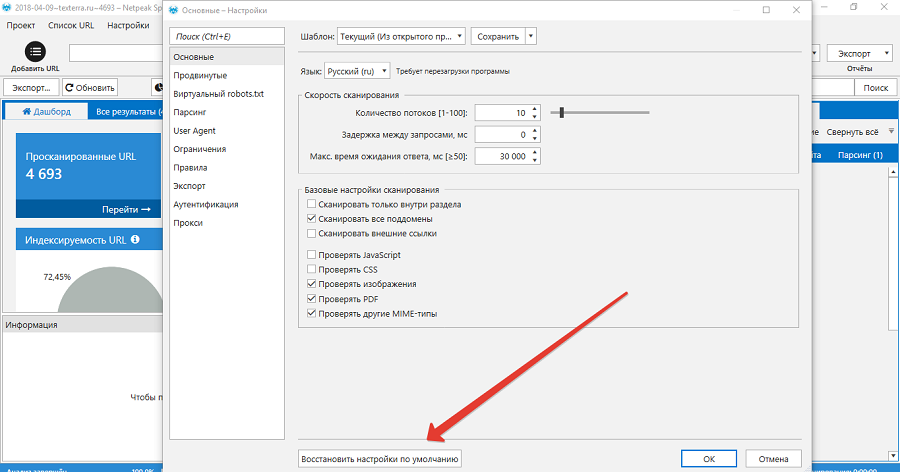

С помощью настроек сканирования можно менять данные, которые собирает Netpeak Spider. Настройки доступны в соответствующем меню программы.

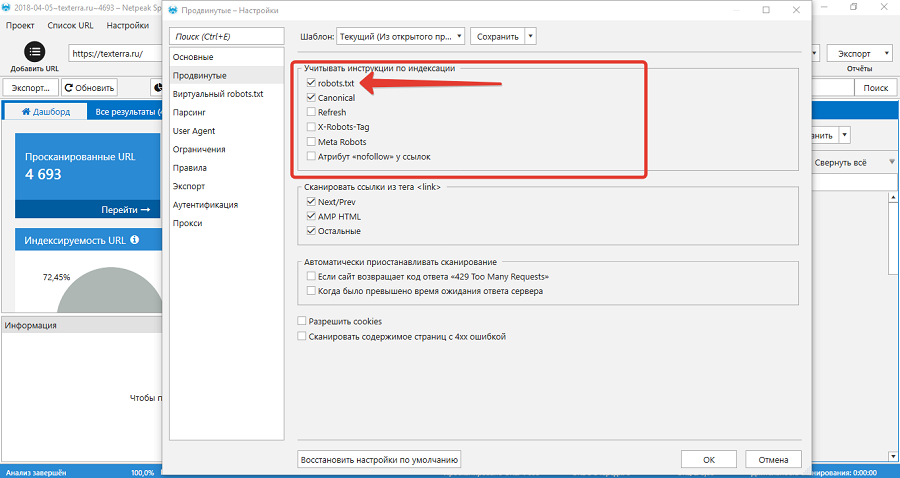

В основных настройках можно выбрать шаблон сканирования, язык программы и скорость сканирования. В базовых настройках сканирования можно включить индексирование раздела. В этом случае, если вы сканируете URL /blog/, робот обойдет только публикации в блоге. Также в базовых настройках можно выбрать тип контента, который индексирует Netpeak Spider. В продвинутых настройках можно настроить индексирование с учетом инструкций для поисковых систем. Netpeak Spider распознает директивы в robots.txt, атрибут rel=canonical, редиректы с задержкой, X-robots-tag, Meta Robots и атрибут rel=nofollow. То есть если нужно просканировать сайт с учетом реальных директив в файле robots.txt, отметьте галочкой соответствующую опцию.

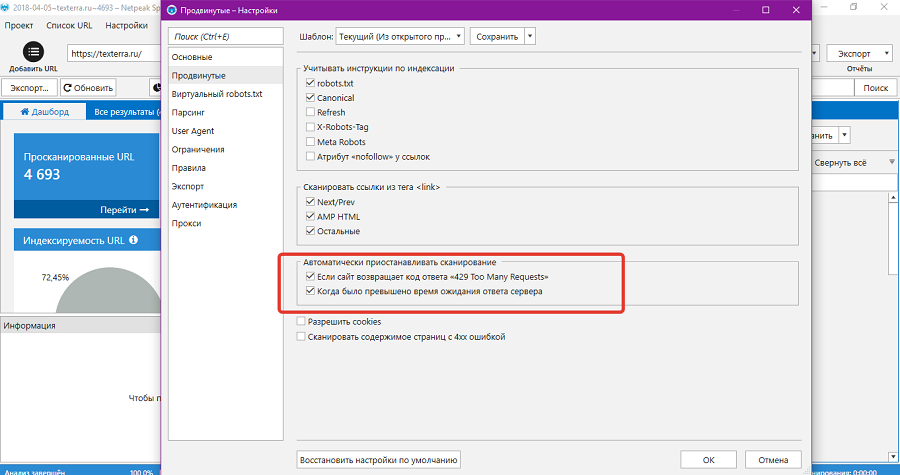

В разделе «Сканировать ссылки из тега link» можно отключить индексирование ссылок на предыдущую и следующую страницу или публикацию, ссылок на ускоренные страницы и на другие ссылки. Также в расширенных настройках можно выбрать условия приостановки сканирования. Netpeak Spider может приостанавливать сканирование на неопределенное время, если сервер возвращает ошибку 429. В этом случае вы можете возобновить сканирование в любой момент. Также программа приостанавливает сканирование на 30 секунд, если время ожидания сервера превышено.

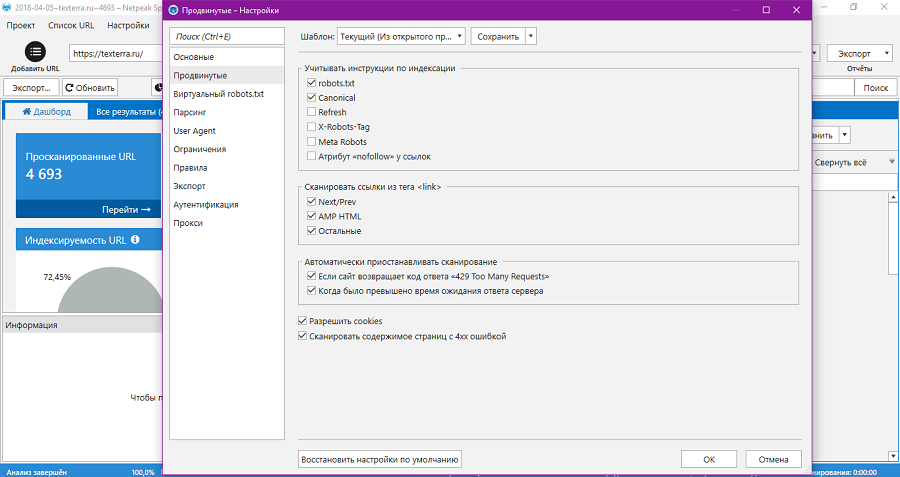

В расширенных настройках можно разрешить cookies и сканирование страниц с ошибкой 4xx. Первая настройка позволяет обходить страницы, которые недоступны без кукис. Вторая позволяет получить доступные данные для страниц, которые возвращают ошибку.

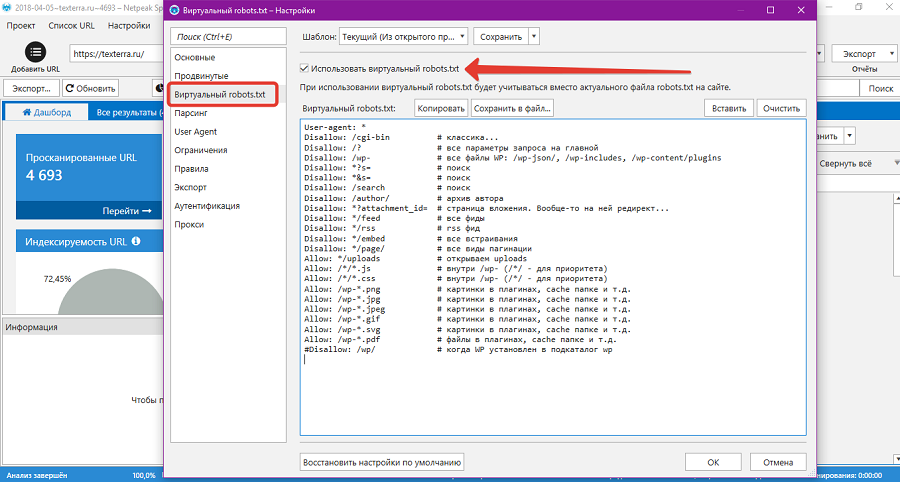

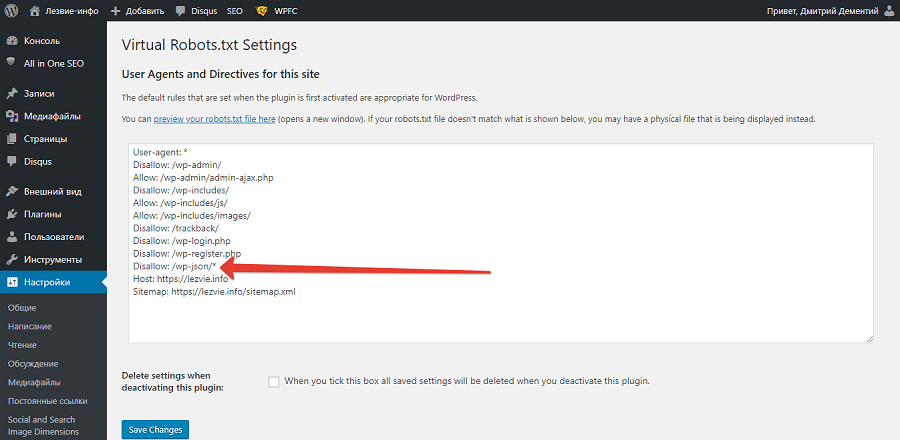

В разделе «Виртуальный robots.txt» можно настроить сканирование с учетом директив виртуального, а не реального файла robots.txt. С помощью этой функции можно проверить корректность файла до его публикации на сайте.

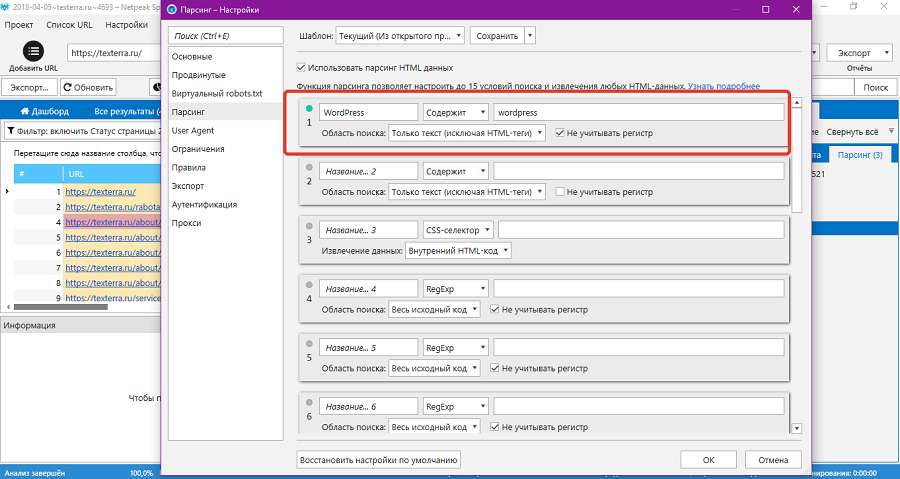

В разделе парсинг можно настроить сбор пользовательских данных. Netpeak Spider поддерживает до 15 шаблонов парсинга одновременно. Парсинг включает четыре способа поиска: В зависимости от выбранного способа можно настроить область поиска. Настройку парсинга стоит рассмотреть на примере. Представьте, что на сайте нужно найти страницы, на которых упоминается какой-то термин. Укажите название шаблона парсинга. С помощью выпадающего меню выберите способ «Содержит». Укажите термин, который нужно искать. С помощью выпадающего меню выберите область поиска «Только текст».

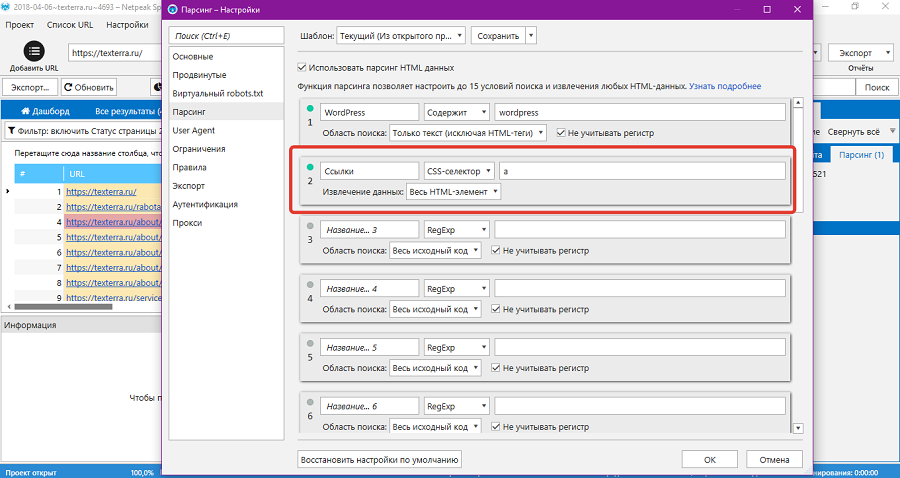

По CSS-селектору можно найти страницы с любыми элементами. Например, с помощью селектора a можно найти страницы со ссылками.

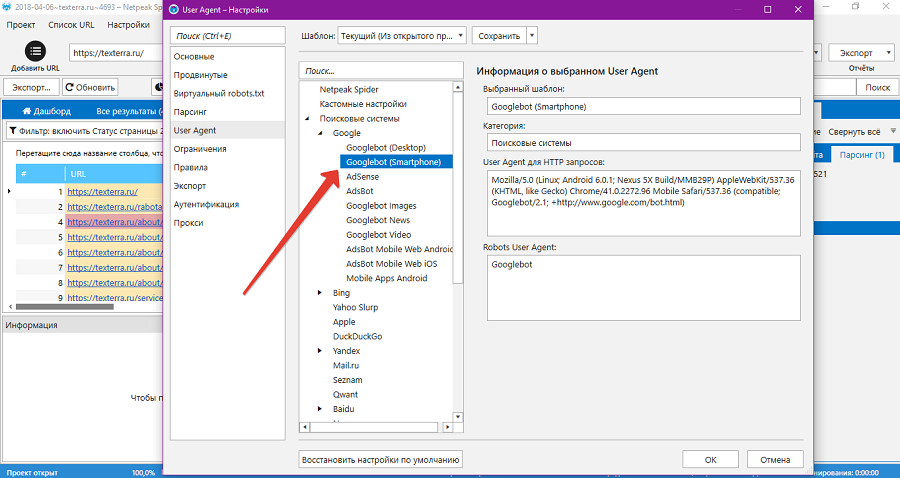

В разделе User Agent можно выбрать шаблон сканирования. По умолчанию включен User Agent Googlebot для десктопов. В контексте тестирования Mobile-First индекса имеет смысл посмотреть на сайт глазами мобильного бота Google. Для этого включите соответствующий шаблон.

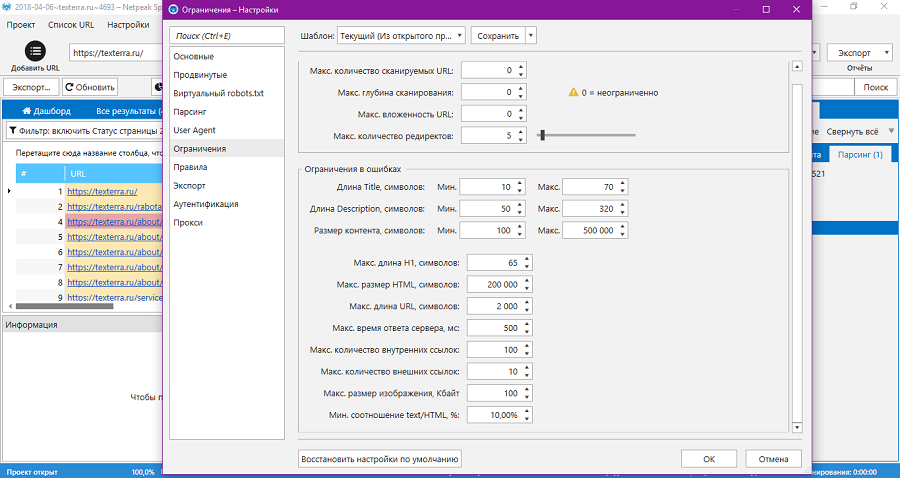

При необходимости используйте других ботов. Новая реальность в поиске: JSON-LD, Mobile-First, ПалехВ разделе «Ограничения» при необходимости измените параметры. Внимания заслуживает опция «Размер контента». По умолчанию Netpeak Spider считает ошибкой контент короче 500 и длиннее 50 000 символов. Уменьшите минимальное значение до 100, а максимально до 500 000, чтобы не тратить время на ложные ошибки. Остальные настройки можно не менять.

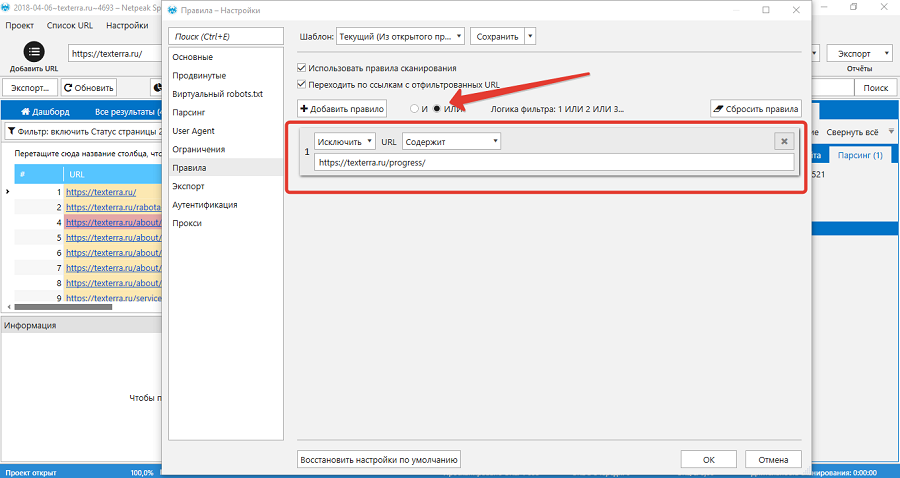

В разделе «Правила» настройте правила сканирования. Доступны два типа фильтров: дефолтный с логикой «или» и продвинутый с логикой «и». Первый срабатывает, когда совпадает хотя бы одно из условий фильтра. Второй предназначен для создания сложных правил, в которых совпадает два и более условий. Например, с помощью правила можно настроить исключения для страниц из раздела «Портфолио» на сайте нашего агентства. Можно добавить в исключения три разные страницы по очереди: «Клиенты», «Отзывы» и «Работы». А можно сэкономить время и исключить все страницы из раздела с помощью одного правила «URL содержит».

Все страницы из раздела «Портфолио» начинаются с URL /progress/, поэтому после настройки фильтра программа будет их игнорировать. В разделе «Экспорт» при необходимости поменяйте дефолтные настройки экспорта данных. В разделе «Аутентификация» добавьте данные доступа к закрытому сайту. В разделе «Прокси» при необходимости укажите прокси-сервера. Как пользоваться дополнительными инструментами Netpeak SpiderИнструменты доступны в соответствующем разделе меню.

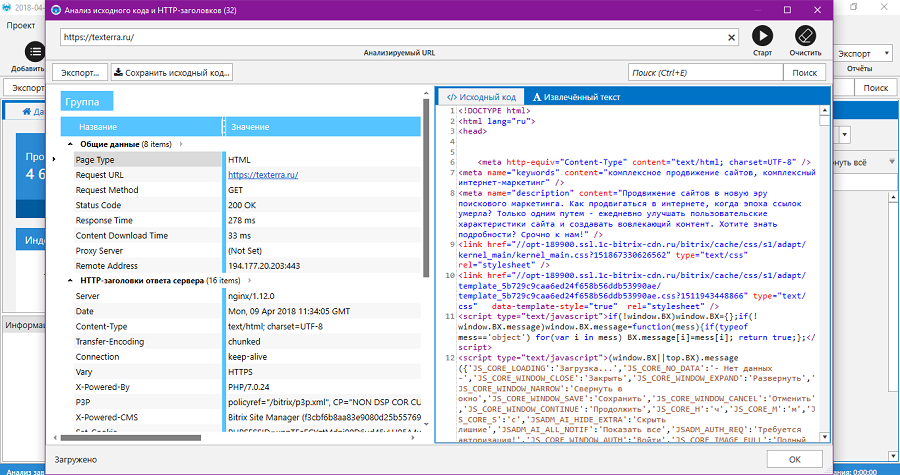

С помощью инструмента «Анализ исходного кода и HTPP-заголовков» можно извлечь и проанализировать соответствующие данные с любой страницы.

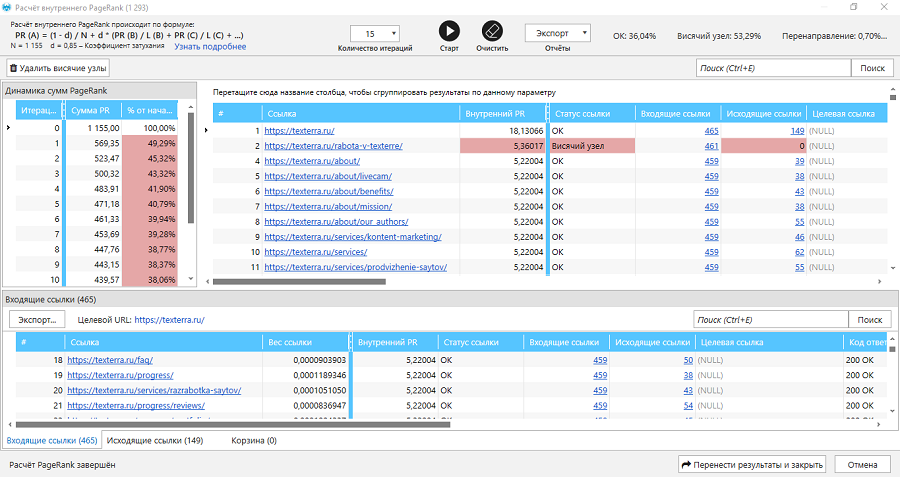

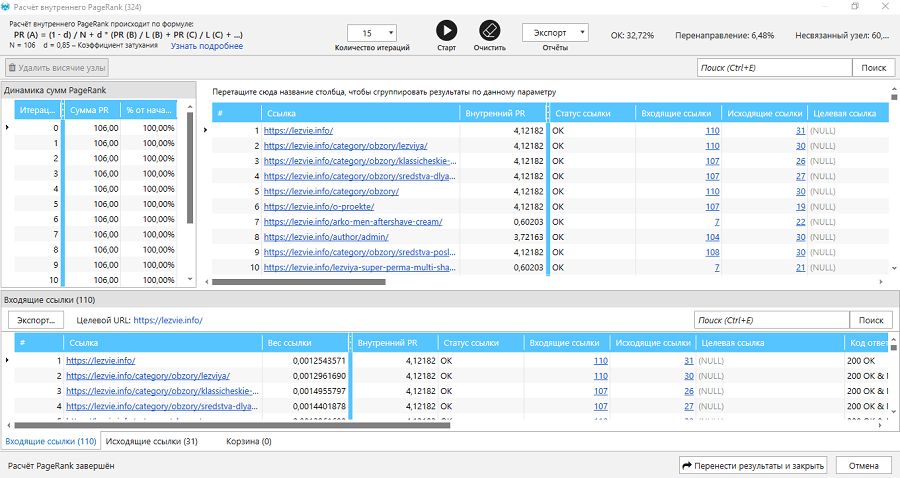

Исходный код страницы можно сохранить на жесткий диск. Также инструмент извлекает текст страницы. Отдельного внимания заслуживает инструмент «Расчет внутреннего PageRank». Согласно терминологии разработчиков Netpeak Spider, PageRank — относительный ссылочный вес страницы. Расчет внутреннего PageRank нужен, чтобы понимать, «как именно распределяется ссылочный вес по сайту и где он концентрируется». Результат анализа внутреннего PageRank выглядит так (см. иллюстрацию).

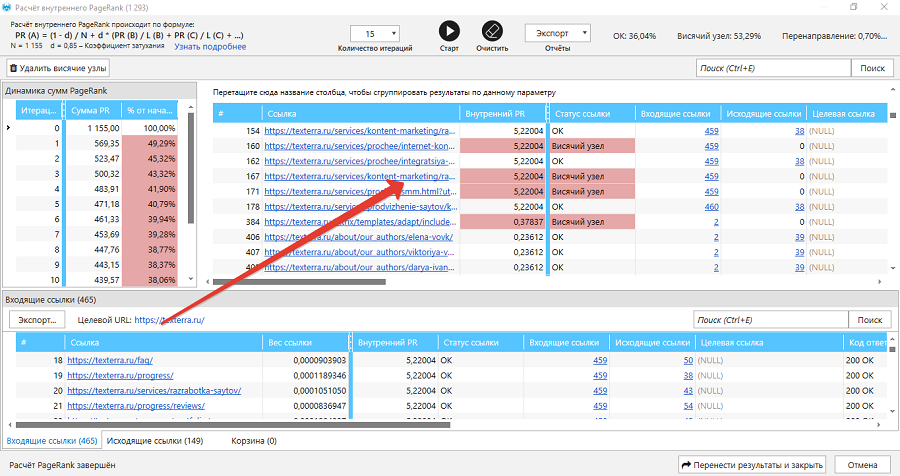

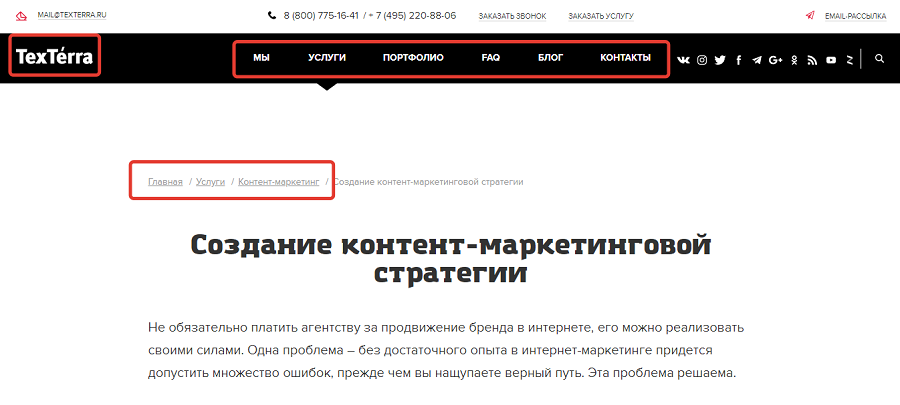

По умолчанию страницы сгруппированы по внутреннему PageRank от большего к меньшему. В столбце «Статус ссылки» указаны разные значения: Например, Netpeak Spider определил в качестве висячего узла страницу услуги «Разработка контент-стратегии».

Это посадочная страница, в тексте которой действительно нет исходящих ссылок. Это сделано специально, чтобы пользователи не ушли со страницы и заполнили конверсионную форму внизу.

Не мешает ли отсутствие исходящих ссылок в тексте страницы распределяться так называемому ссылочному соку? Внимание на иллюстрацию.

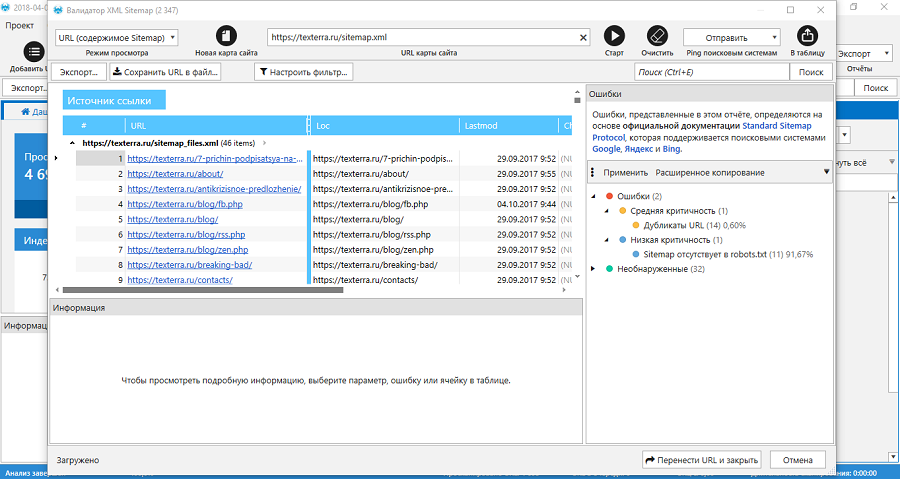

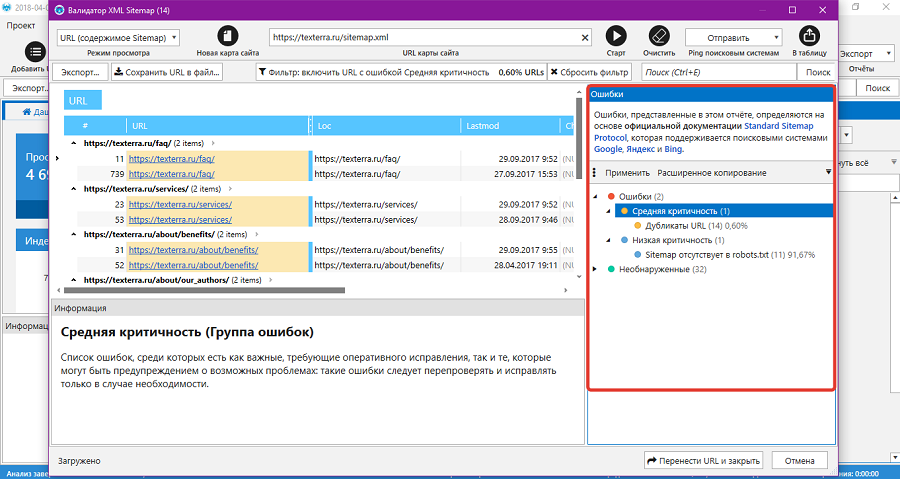

Инструмент «Анализ внутреннего PageRank» нужно использовать аккуратно. Он формирует сеошное отношение к внутренней перелинковке. У неопытного вебмастера может появиться желание добавить на «висячие узлы» ссылки не ради удобства пользователей, а ради полумифического перетекания ссылочного сока. Из-за этого может пострадать юзабилити и конверсия. Пример с отсутствием исходящих ссылок на лендинге это подтверждает. Моя позиция: если на сайте есть меню, реализованы хлебные крошки, навигация по категориям, забудьте про перетекание ссылочного сока. Перелинковывайте страницы ради счастья пользователей, а не ради SEO. А ссылочный сок перетечет без вашего участия. Кстати, Google давно отказался от публичного расчета PageRank. С помощью валидатора XML Sitemap можно проанализировать карту сайта. Для этого укажите соответствующий URL и нажмите кнопку «Старт».

Чтобы просмотреть информацию об ошибках, нажмите на соответствующие ссылки в правой части экрана программы.

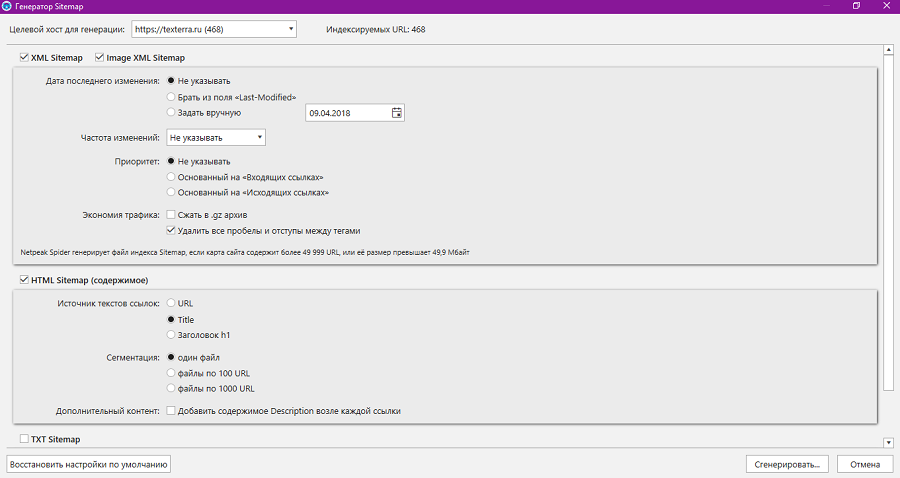

Инструмент «Генератор Sitemap» создает карту сайта для выбранного сайта. Дефолтные настройки корректные, но при необходимости их можно менять. Например, для больших сайтов имеет смысл разделить карту сайта на сегменты по 100 или 1000 URL. Для экономии трафика можно заархивировать карту сайта.

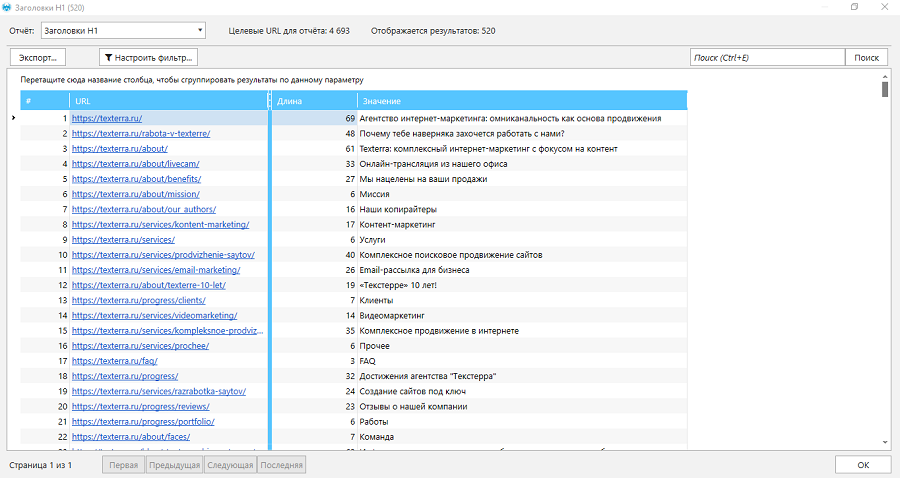

В разделе меню «Анализ» можно получить данные о дубликатах, входящих ссылках и цепочках канонических URL. В меню «Базы данных» можно вызвать сводку по парсингу, перейти к общим результатам сканирования и к таблице заголовков URL.  Мини-кейс: как Netpeak Spider помог устранить ошибки на сайте

Мини-кейс: как Netpeak Spider помог устранить ошибки на сайте

Для мини-кейса использовал свою экспериментальную площадку, так как здесь не боюсь что-нибудь сломать. Перед началом работы с Netpeak Spider восстановил настройки по умолчанию.

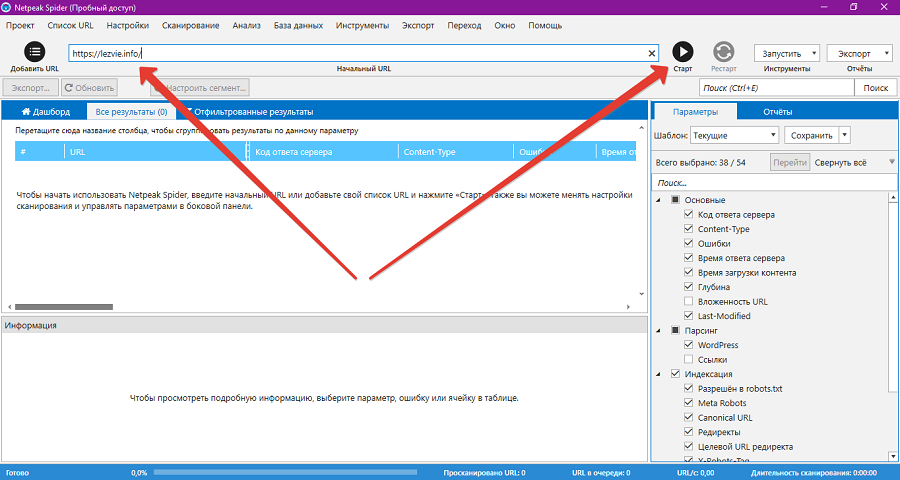

Указал URL ресурса и запустил сканирование.

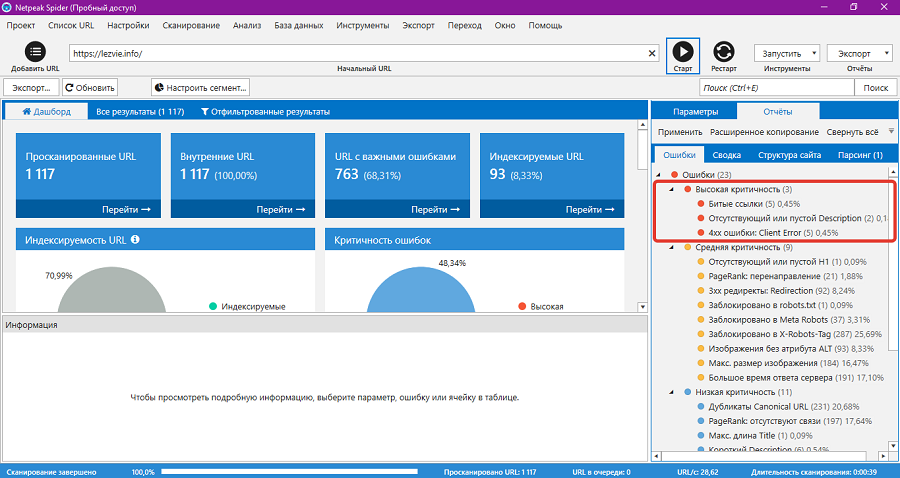

В течение минуты получил результат сканирования. В первую очередь интересуюсь ошибками с высоким уровнем критичности.

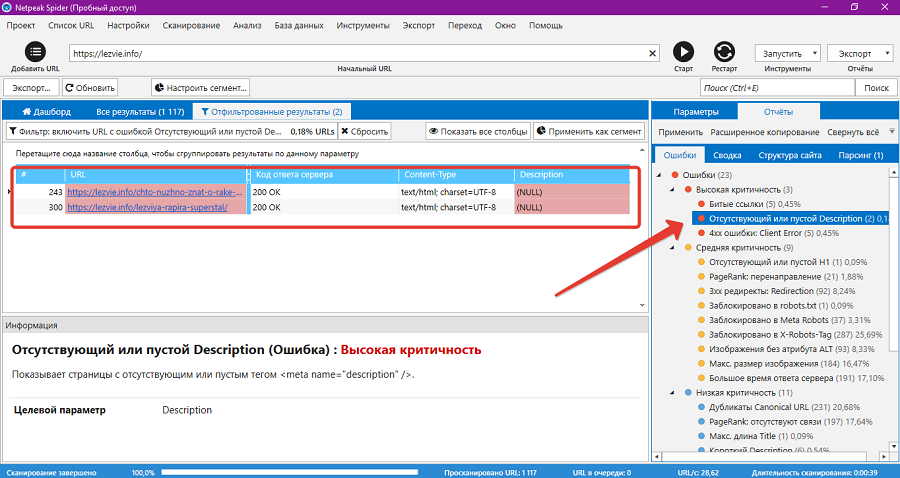

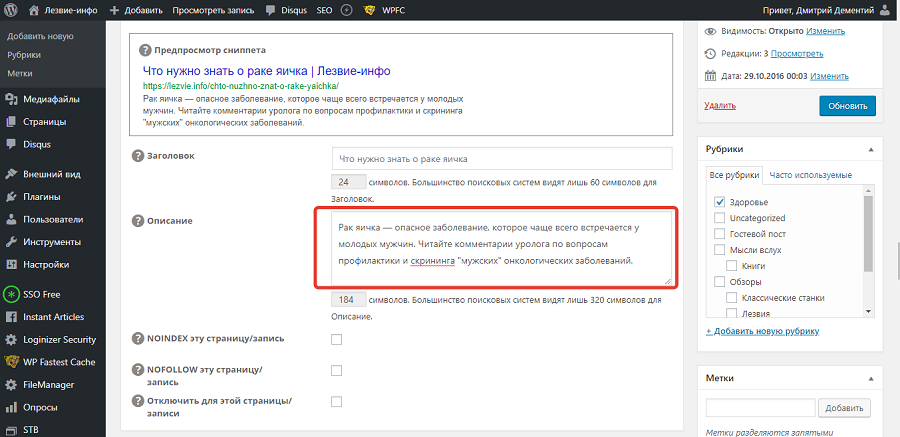

Начал с простого: добавляю дескрипшен на две страницы.

В админке сайта увидел, что описания действительно нет. Исправил ошибку на двух страницах.

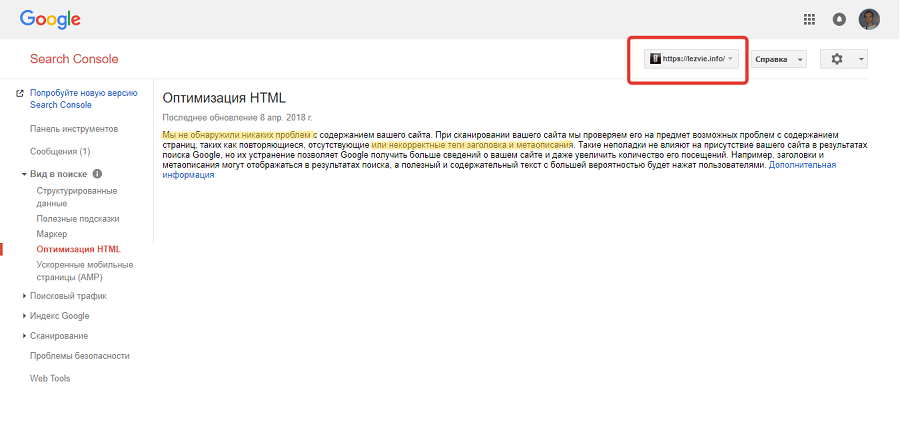

Кстати, в Search Console Google уведомления об отсутствующих description нет.

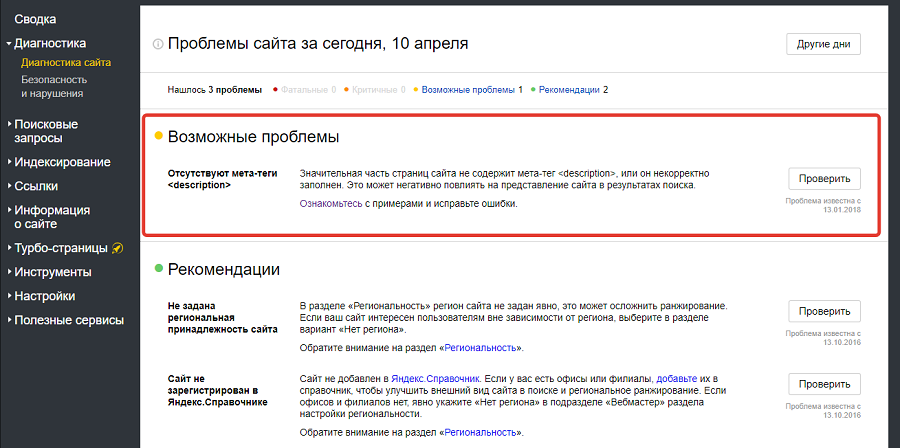

Справедливости ради, в «Вебмастере» в разделе возможных ошибок висит уведомление об отсутствии description.

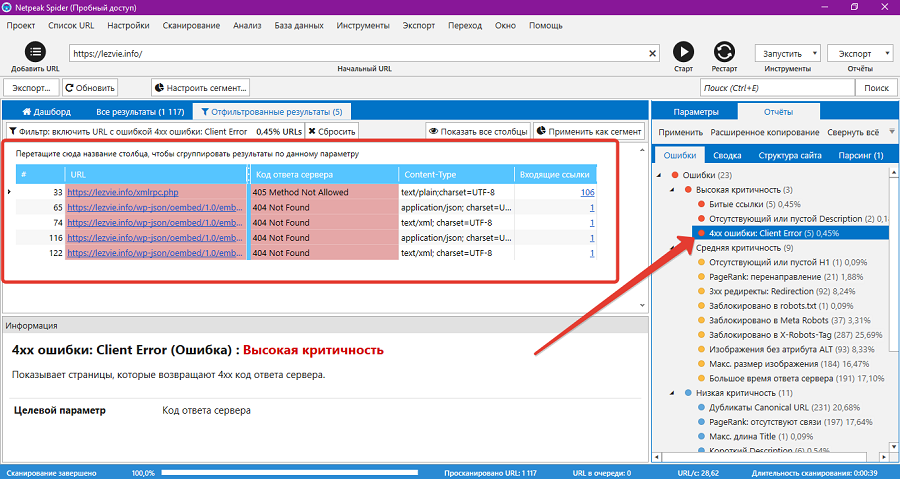

Анализирую критические ошибки «Битые ссылки». Первую ошибку игнорировал, так как доступ к xmlrpc.php закрыл сам из-за параноидального стремления обезопасить сайт от взломщиков.

Остальные битые ссылки указывают на виртуальный каталог REST API. Такие ссылки желательно закрывать от индексации. Например, это можно сделать через robots.txt.

Ошибки Client Error также связаны с xmlrpc.php и каталогом wp-json для REST API. Ссылки уже закрыты от индексации поисковыми системами, поэтому их можно игнорировать.

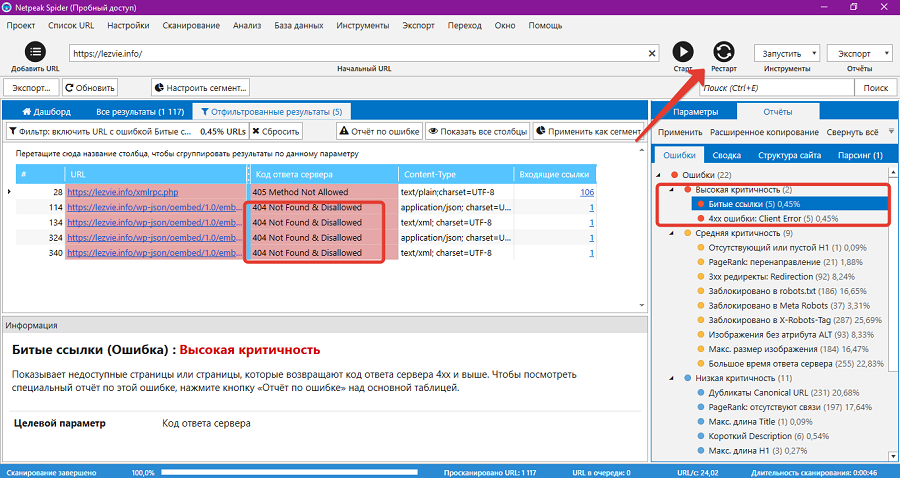

С помощью кнопки «Рестарт» повторил сканирование, чтобы увидеть реакцию программы на исправленные ошибки. На иллюстрации видно, что предупреждения об отсутствующих description исчезли. Статус битых ссылок на каталог wp-json изменился с Not Found на Not Found и Disallowed. То есть проблемные служебные ссылки закрыты от индексации поисковиками.

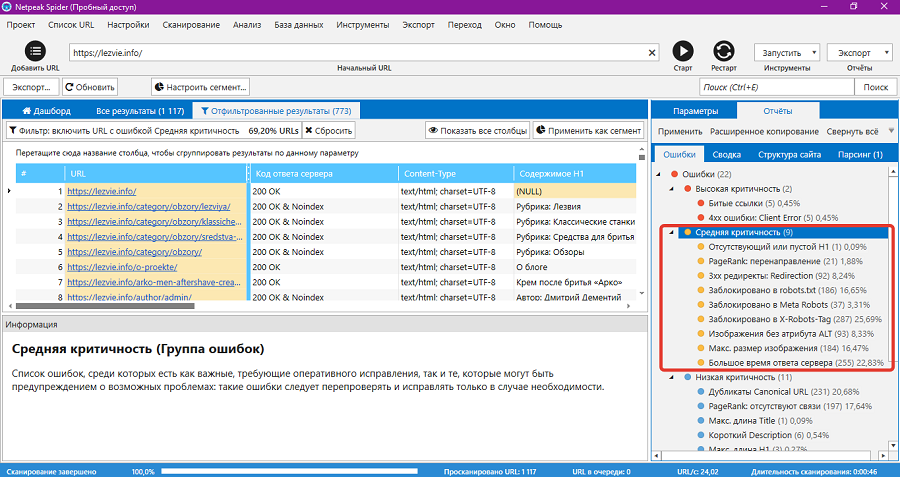

После устранения критичных ошибок проанализировал проблемы средней критичности.

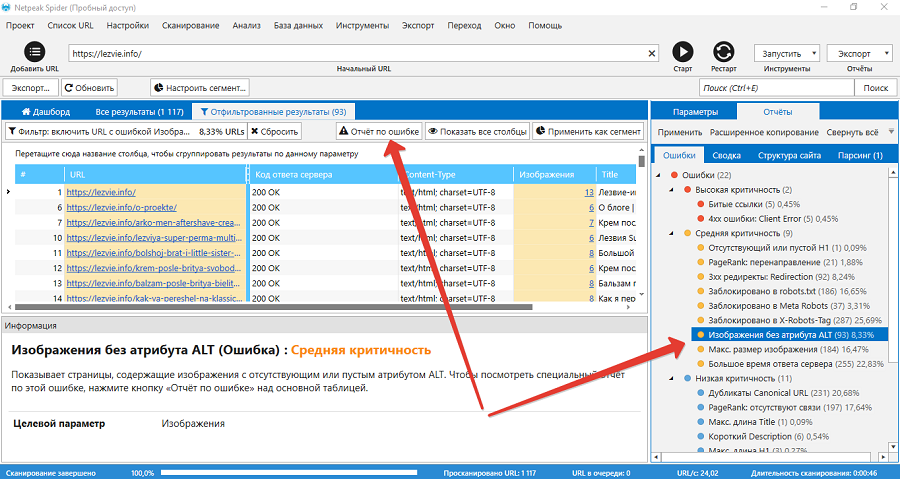

Часть предупреждений не требует внимания, это не ошибки: Другие ошибки требуют внимания. Например, ошибку «Изображения без атрибута Alt» надо исправлять. С помощью кнопки «Отчет по ошибке» я получил список страниц, на которых есть фото без атрибута Alt. Фронт работы понятен.

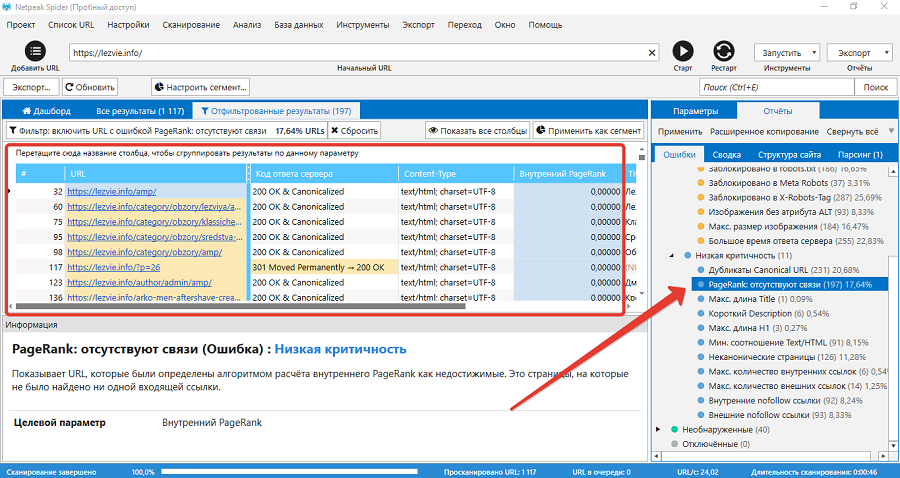

Также требуют исправления ошибки: После анализа ошибок со средним уровнем критичности уделил внимание некритичным ошибкам. Они не требуют немедленного исправления. Этими ошибками займусь, если будут чесаться руки. Например, Netpeak Spider включает в ошибку «PageRank: отсутствуют связи» все ускоренные страницы сайта.

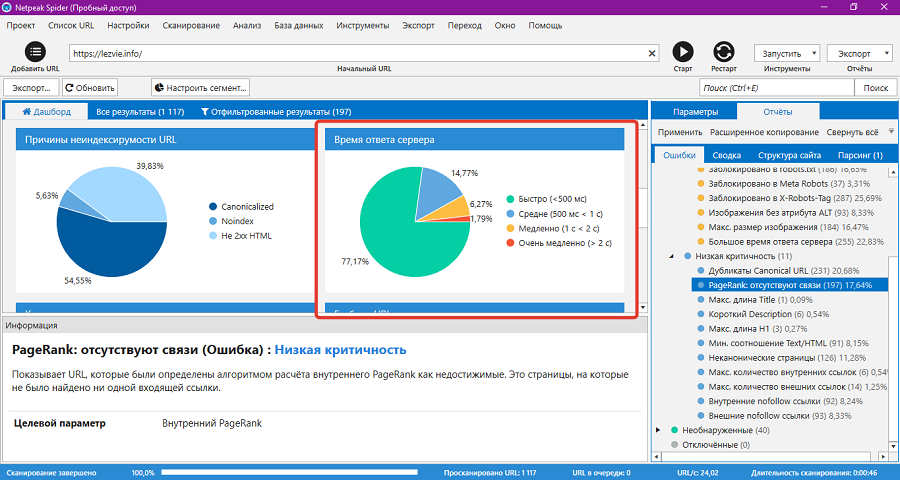

Уведомляю Google о наличии ускоренной версии страниц с помощью атрибута rel="amphtml". Не считаю нужным уведомлять об AMP-версии сайта пользователей, которые попали на полную версию. Google сам направляет пользователей на AMP, если считает нужным. То есть ошибки нет. Пытаюсь достать из результатов сканирования полезные данные, которые помогут работать над сайтом. На дашборде вижу, что время ответа сервера для 2 % страниц сайта превышает 2 секунды.

Ради интереса рассчитываю внутренние PageRank. Программа ранжирует страницы по ссылочному весу и присваивает им статусы Ok, «Перенаправление» или «Несвязный узел». Несвязными узлами Netpeak Spider называет AMP, на которые нет ссылок. Перелинковка на моем сайте настроена корректно и с заботой о пользователе, поэтому практически полезной информации в расчете внутреннего PageRank не вижу.

Что в итоге: с помощью Netpeak Spider нашел несколько важных ошибок. Это отсутствие description на двух страницах, индексируемые ссылки на каталог wp-json, отсутствие атрибута alt у некоторых фото и медленный ответ сервера для 2 % страниц сайта. Часть ошибок, например, отсутствующие метатеги и атрибуты alt, можно исправить быстро. Над другими, в частности, над скоростью загрузки страниц и временем ответа сервера, придется работать дольше. При необходимости могу извлечь из результатов сканирования другие полезные данные, о которых шла речь в описании функциональности программы. Мы занимаемся разработкой сайтов. Подробнее Эффективность Netpeak Spider зависит от квалификации пользователяNetpeak Spider — инструмент для квалифицированных пользователей. Программа мгновенно собирает информацию о сайте. От владельца сайта зависит реальная польза полученных сведений. Netpeak Spider находит серьезные ошибки, которые не видит Search Console. Также с помощью программы можно получить данные о структуре сайта, идеи для навигации и перелинковки. Благодаря пользовательскому парсингу возможности Netpeak Spider практически безграничны. С помощью этого инструмента можно получить любые данные с публичного сайта. Это может быть список страниц с использованием определенного термина, элемента, фрагмента кода. Неквалифицированные пользователи должны пользоваться Netpeak Spider аккуратно. В лучшем случае работа с программой грозит ламеру потерей времени. А в худшем пользователь может неверно трактовать собранную информацию и допустить ошибки в работе с сайтом. Впрочем, это справедливо в отношении любого инструмента. Про топор в руках известного литературного героя говорили выше. Делитесь опытом использования Netpeak Spider в комментариях. Как вы используете полученные с помощью программы данные для улучшения своего сайта или конкурентного анализа? Какие функции программы нравятся, а какие кажутся непонятными или бесполезными? chto-umeet-netpeak-spider-moshchnyy-instrument-seo-analiza-sayta | |

|

| |

| Всего комментариев: 0 | |